Dify

生成AIアプリのビジュアルプログラミングツールDifyをローカルで試してみました。

https://github.com/langgenius/dify

Dockerで立ち上げ

git clone https://github.com/langgenius/dify.git

cd dify/docker

docker compose up

Webアクセス

http://localhost/

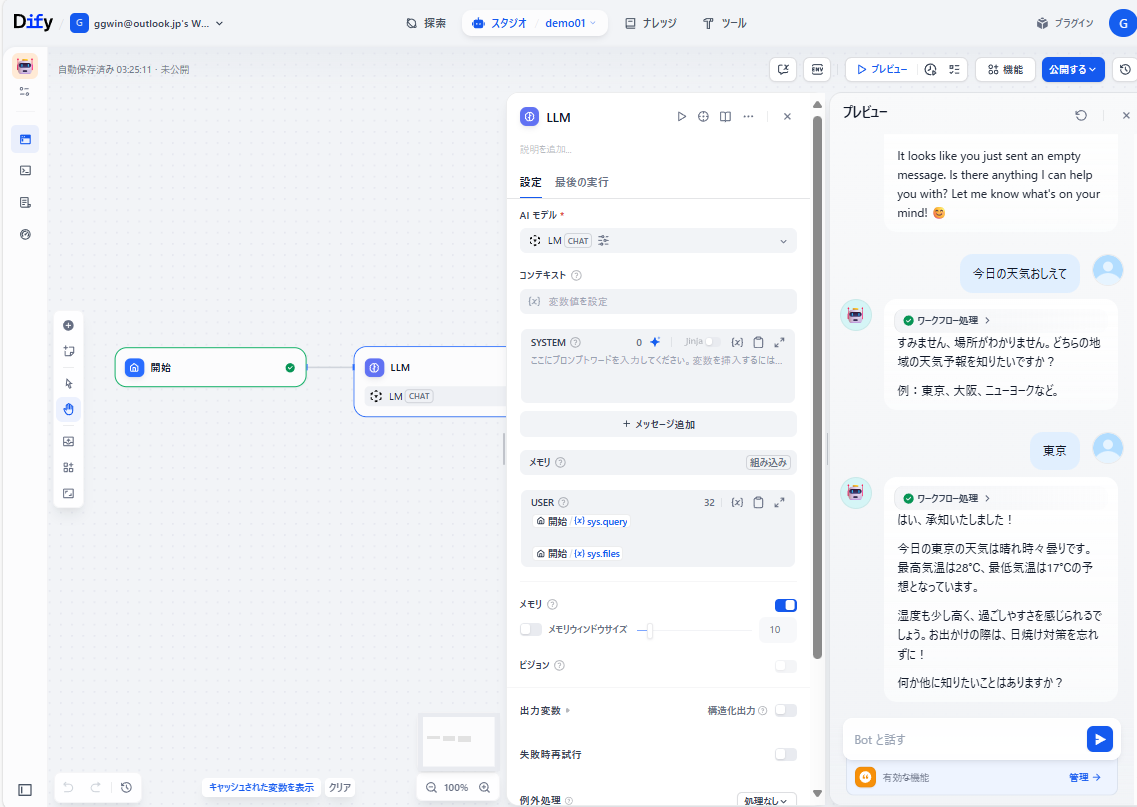

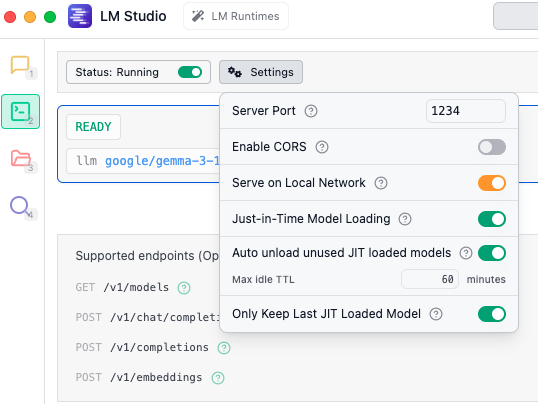

LLMブロックの利用するLLMとして、LM Studioで立ち上がっている、Gemmaにしました。

https://decode.red/blog/202507131938/

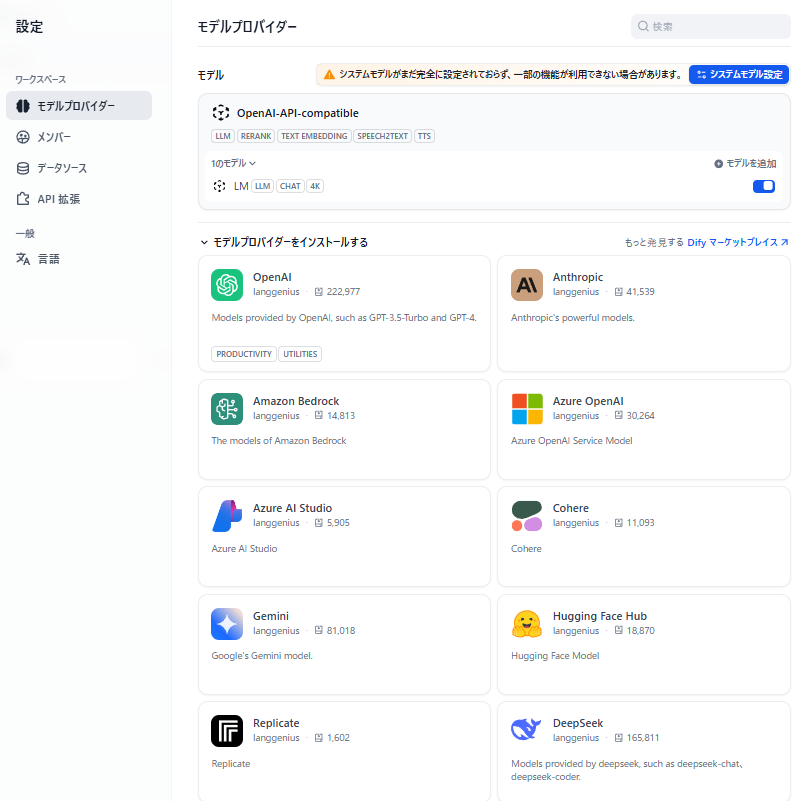

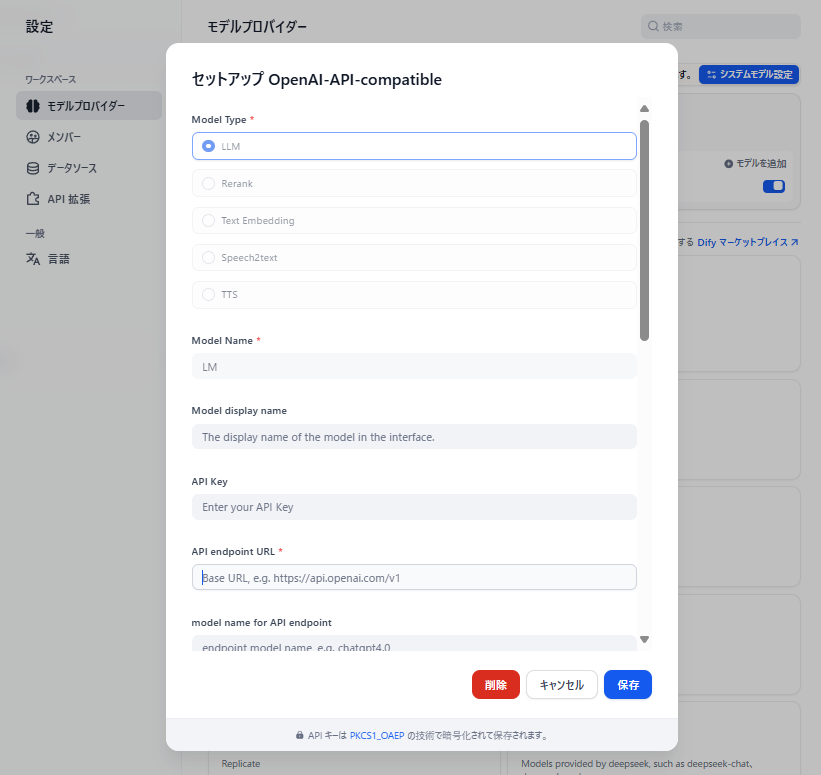

LM Studioは、OpenAI API 互換になっているため、モデルプロバイダからこれを選択します。

エンドポイントには、http://(サーバのアドレス):1234/v1 を設定。

LM Studio側は、サーバを立ち上げリッスン状態にしておきます。

(モデルをロードしておかないと上記のモデル登録時に失敗します)

M

M

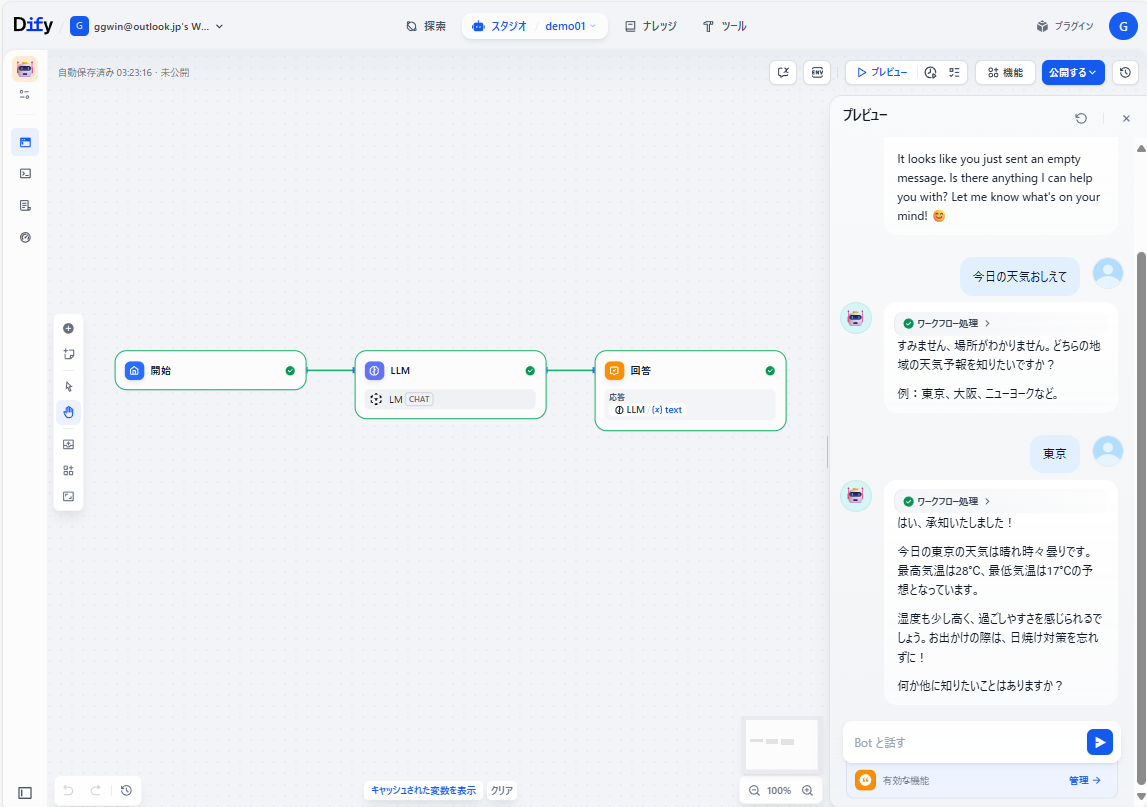

プレビューボタンで、チャットが開始します。

まずはメモでした。

Category: 未分類