n8nのワークフローをプロンプトの指示で作ることができるMCPを試してみました。

https://github.com/czlonkowski/n8n-mcp

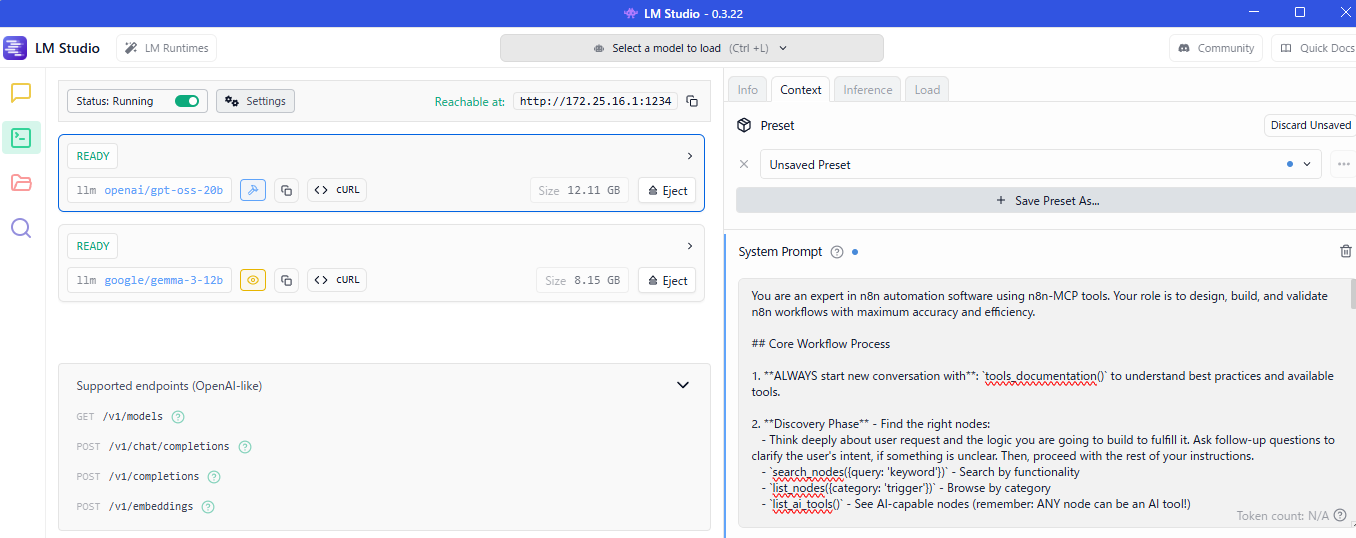

今回出たばかりのgpt-oss-20bをLM Studioで使いました。Claude Project Setupとして入力するプロンプトをLMのSystem Prompt に、MCP設定もLMにしました。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 |

{ "mcpServers": { "n8n-mcp": { "command": "npx", "args": [ "n8n-mcp" ], "env": { "MCP_MODE": "stdio", "LOG_LEVEL": "error", "DISABLE_CONSOLE_OUTPUT": "true" } } } } |

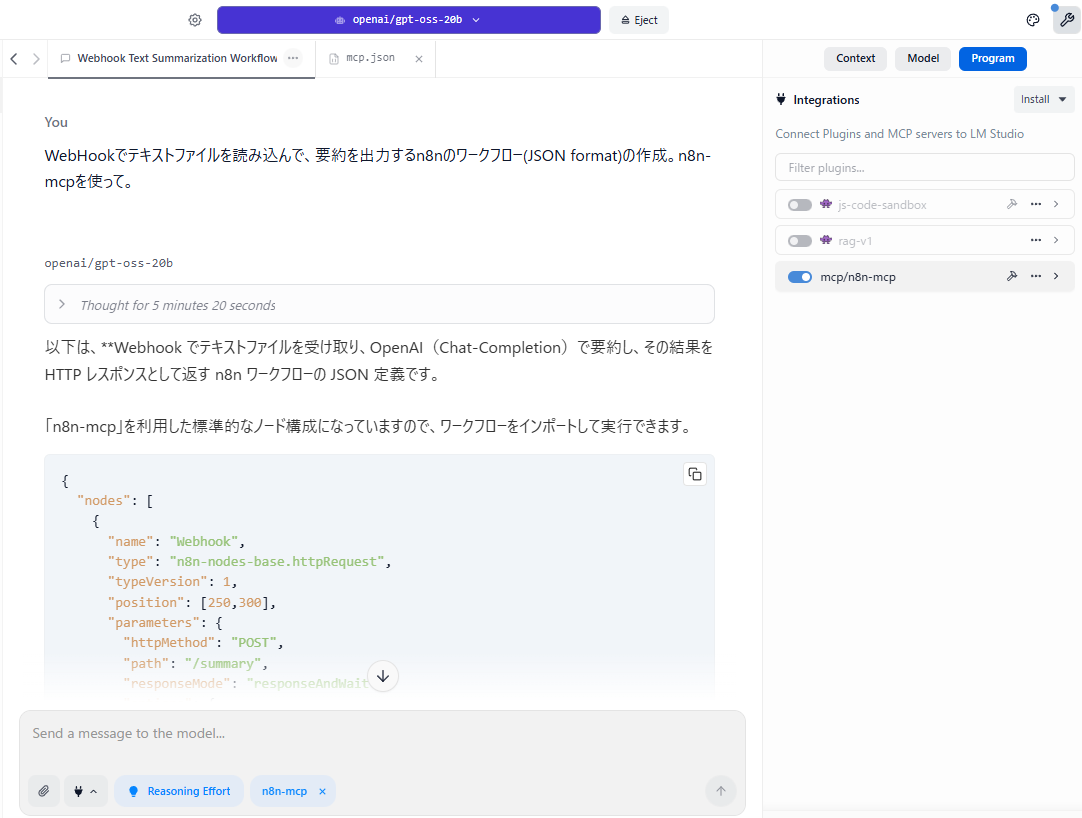

設定が済んだら、プロンプトに指示をだします。この指示に至るまで、さまざまなもの(X-twitter,PDFなど)を試しましたが、ノードがなかったり、ノードの接続がうまくいかなかったりして結局これになりました。

作成したJSONもそのままでは使えずChat-GPTに修正をさせました。これはgpt-ossを使っているせいもあるかもしれませんが、すべて無料というチャレンジをしてみました。 Claudeのプロジェクトを使うことや、サイズの大きいプロンプトを使うことは有料になるため、ローカルLLMで試しました。

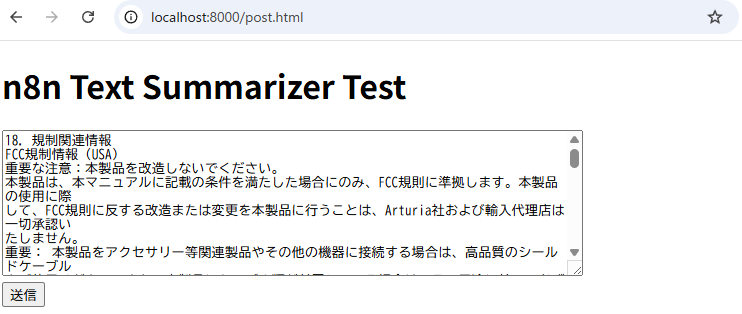

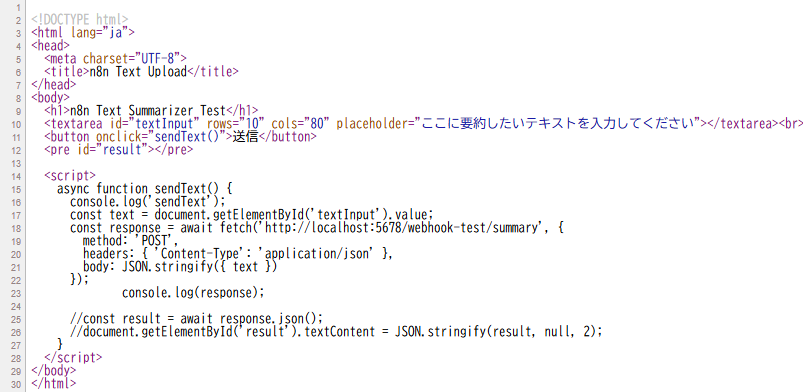

python -m http.server 8000

テキストファイルは前回もつかったマニュアルの一部で、Webからアップロードしました。CORSの設定は下記。

docker run -d –name n8n -p 5678:5678 -e NBN_DEFAULT_CORS=TRUE -e N8N_CORS_ALLOW_ORIGIN=* -e N8N_BASIC_AUTH_ACTIVE=true -e N8N_BASIC_AUTH_USER=ggwin@outlook.jp -e N8N_BASIC_AUTH_PASSWORD=password -v /home/k/.n8n:/home/node/.n8n n8nio/n8n

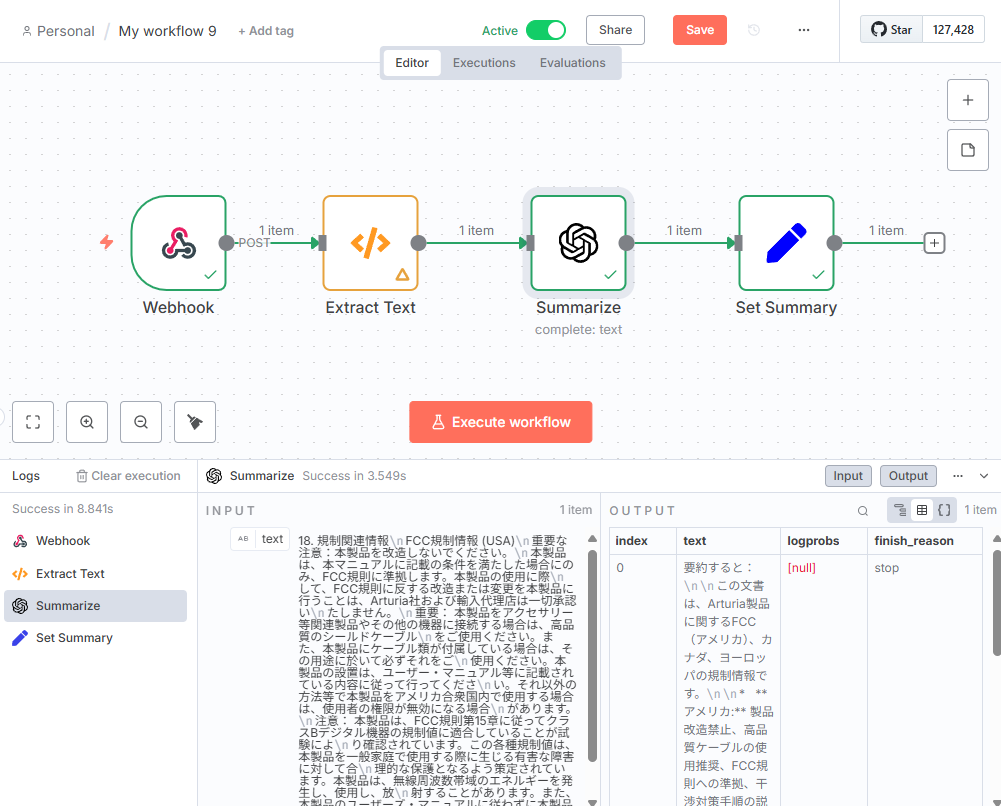

「Execute Workflow」をクリックすると、リッスン状態になり、テキスト送信をすると動き出します。

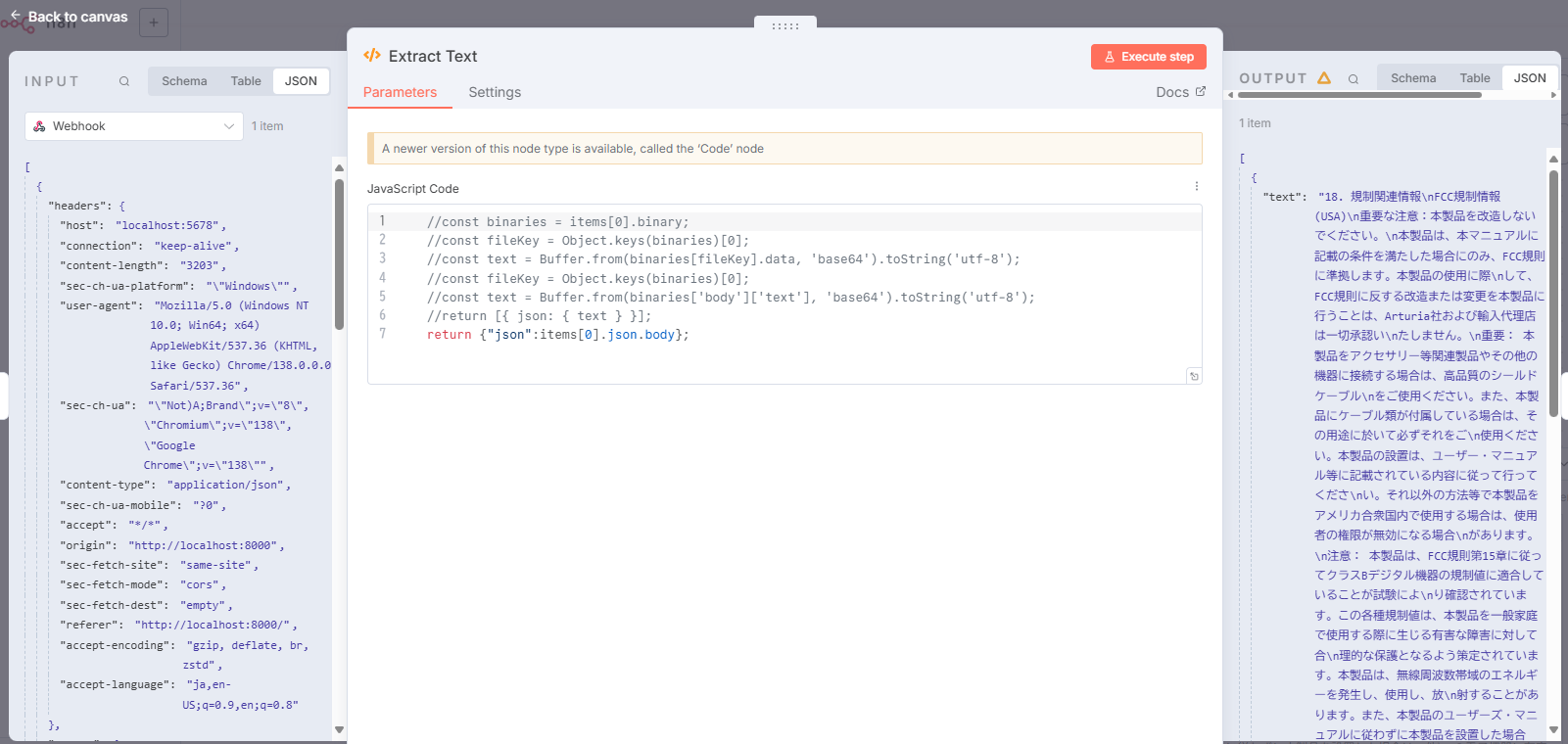

summarizeに渡す部分は上記のように修正しました。

summarizeから呼び出すAIエージェントはgpt-ossが時間がかかりすぎたので、gemmmaにしました。

set summary はあまり意味がありませんでした。

まだわからないことばかりで、いろいろ手間がかかりましたが、MCPの使い方としてとても面白いと思いました。

ノードもたくさんあり、思い通りに使うためには、まだ時間がかかりそうです。